개념은 이 블로그를 참고했다.

https://dgkim5360.tistory.com/entry/understanding-long-short-term-memory-lstm-kr

Long Short-Term Memory (LSTM) 이해하기

이 글은 Christopher Olah가 2015년 8월에 쓴 글을 우리 말로 번역한 것이다. Recurrent neural network의 개념을 쉽게 설명했고, 그 중 획기적인 모델인 LSTM을 이론적으로 이해할 수 있도록 좋은 그림과 함께

dgkim5360.tistory.com

개념 요약

1. RNN은 비교적 짧은 시간 전의 정보를 기억해 모델에 활용하지만 긴 시간 이전의 정보를 기억하긴 쉽지 않다.

2. LSTM은 긴 시간 이전의 정보도 잘 기억하고 이를 잘 활용하도록 학습한다.

3. LSTM은 이전 정보를 없애거나 더하며 원하는 정보를 계속해서 학습해간다

역전파/순전파 개념은 이 블로그를 참고했다.

https://ratsgo.github.io/natural%20language%20processing/2017/03/09/rnnlstm/

RNN과 LSTM을 이해해보자! · ratsgo's blog

이번 포스팅에서는 Recurrent Neural Networks(RNN)과 RNN의 일종인 Long Short-Term Memory models(LSTM)에 대해 알아보도록 하겠습니다. 우선 두 알고리즘의 개요를 간략히 언급한 뒤 foward, backward compute pass를 천천

ratsgo.github.io

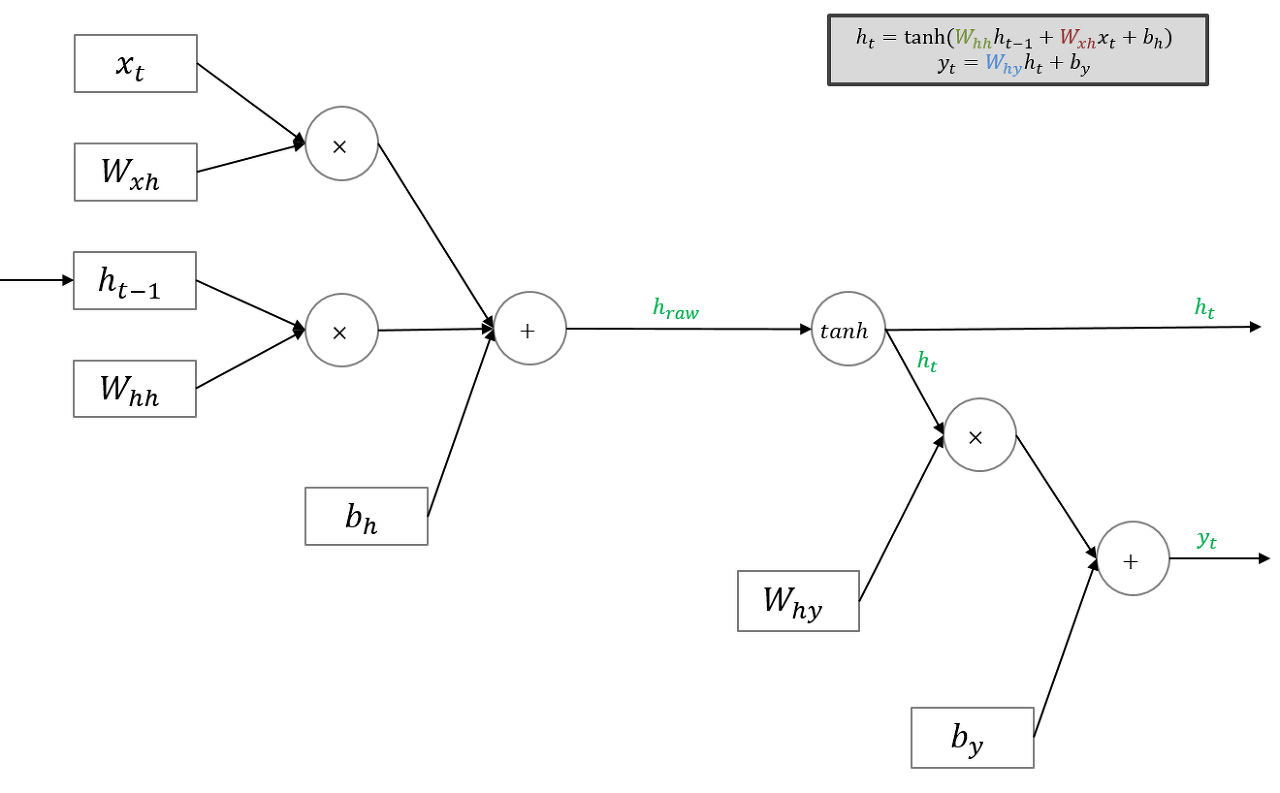

RNN

순전파/역전파

순전파

역전파

요약해보면

1. 순전파 : 주어진 정보를 학습해 타겟을 추측하며 Parameter 세팅

2. 역전파 : 추측 결과와 알려진 정답을 비교하며 loss를 토대로 Parameter 재조정

3. 관련 정보와 그 정보를 사용하는 지점 사이 거리가 멀 경우 역전파시 그래디언트가 점차 줄어 학습 능력이 크게 저하

-> Vanishing Gradient Problem

'프로젝트(진행중) > 머신러닝 한 걸음씩' 카테고리의 다른 글

| 추천 시스템 정리 (0) | 2022.02.21 |

|---|---|

| Accuracy(정확도), Recall(재현율), Precision(정밀도), F1 Score 총정리 (0) | 2021.10.05 |

| EP 04. KNN(최근접 이웃) 개념과 장단점 (0) | 2021.09.06 |

| EP 03. 나에게 필요한 머신러닝 찾아내는 방법(with 생활코딩) (0) | 2021.08.01 |

| EP 02. 과적합과 정규화 (0) | 2021.07.26 |

댓글